Depuis environ 6 mois, une large place a été faite dans l’actualité pour les « langageurs » (ou « LLMs », large langage models). Avec de formidables réussites, beaucoup d’espoirs d’usages nouveaux, en rupture… et beaucoup de questions quant à la possibilité d’utiliser leurs résultats sur des usages à forts enjeux (hallucinations ? citations de sources fiables ? confidentialité des données ?)

Pour ces modèles, comme pour tous les autres, se posent donc la question de leur déploiement avec confiance, et … de leur explicabilité.

Quand il s’agit d’expliquer un modèle, deux approches standard sont généralement considérées :

La 1ère est actuellement la seule véritablement employée (cf. « Sparks of AGI » de Sébastien Bubeck, Microsoft). Mais elle est insuffisante pour utiliser avec certitude ces modèles (« quelle réponse pour un « prompt » que je n’ai pas testé ? »)

La 2ème est particulièrement difficile dans le cas des langageurs actuels, du fait de leur taille, et de leur nature même (apprentissage statistique).

C’est cependant la 2ème approche qui permettra, d’une façon ou d’une autre d’apporter des garanties suffisantes à l’usage effectif plus « autonome » de ces nouveaux outils d’IA tout en gardant un contrôle humain suffisant.

Afin de saisir les enjeux associés, nous vous proposons une plongée vers les années 2000, et de construire une intuition du fonctionnement global de ces modèles via… le « topic modeling », ou modélisation automatique de thèmes.

En effet : tokens ? embeddings ? base de vecteurs ? ces notions ramènent aux idées structurantes ayant « émergé » dans les années 2000/2003 pour obtenir une « intuition » du fonctionnement général des modèles de génération de langage, et de leur étonnante efficacité (et limites intrinsèques).

Une illustration particulièrement riche d’enseignements nous renvoie vers les travaux de David Blei et Andrew Ng sur la modélisation de thèmes dans des corpora textuels, sur lesquels s’appuient les paragraphes suivant.

Illustrons d’abord ce qu’est cette modélisation automatique de thèmes (« topic modeling »).

Moissonner des informations sur internet (réseaux « sociaux », forums et sites spécialisés) pour observer par exemple l’émergence des tendances du moment, des sujets de discussion est une des applications de Data Science largement déployée, à présent bien documentée.

On distingue souvent plusieurs étapes :

AI-vidence est intervenu comme de nombreux acteurs sur ce sujet. Avec une spécificité : commencer par le souci in fine de l’explicabilité des résultats. En effet, ces approches sont non-supervisées, automatiques. L’explicabilité in fine des résultats y est d’autant plus un point clef.

N’hésitez pas à nous contacter pour plus d’informations.

Plongeons à présent dans l’algorithme qui a longtemps été l’état de l’art en découverte automatique de thèmes (les lecteurs les plus pressés pourront passer au paragraphe suivant 😀 )…

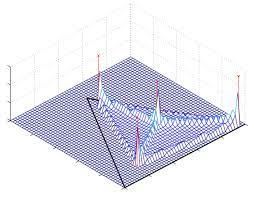

L’idée majeure de l’allocation latente de Dirichlet est précisément celle qui a porté le plus de fruits dans l’approche actuelle, statistique des IA génératives. Il s’agit de décrire les mots non par leur sémantique, signification intrinsèque, mais par les relations qu’ils entretiennent les uns envers les autres. On mesure alors la probabilité qu’un mot soit présent en même temps que chacun des autres dans un texte. Cette probabilité est mesurée en constatant dans de nombreux paragraphes, verbatims, les occurrences simultanées de certains mots.

La représentation d’un mot n’est donc pas le mot lui-même, mais le vecteur des probabilités de présence simultanées dans des ensembles textuels. On parle alors de « plongement » du mot dans son contexte (« embedding« ). Mathématiquement, on mesure donc une distribution de probabilités de présence conjointe dans un même texte.

Une fois ces mots ainsi décrits, comment arriver à des thèmes ?

La représentation d’un thème est elle-même un « plongement » de ce thème dans l’ensemble des mots. Cela revient globalement à créer une structure « au-dessus » de la structure des mots, qui est une structure de thèmes, et qui mesure également la probabilité d’apparition de ces thèmes dans des ensembles textuels. Cette double structure est finalement ce qui décrit le mieux les thèmes, et la structure qu’ils entretiennent entre eux dans les corpora textuels dans leur entier. Elles ne sont pas explicites, mais sous-jacentes. On parle alors de structures latentes.

Johann Peter Gustav Lejeune Dirichlet était un mathématicien allemand remarquable du XIXème siècle, qui a travaillé notamment sur les distributions de distributions. Cette approche d’identification de structures latentes doubles a ainsi été baptisée en son honneur.

Quel lien éclairant établir entre les langages actuels, et ces distributions de mots / thèmes ?

L’idée vient de l’approche intrinsèquement hiérarchique (ou pour le moins, multi-échelles) des langageurs actuels. Comme les algorithmes de LDA (Latent Dirichlet Allocation), l’approche volontaire, ou émergente reproduit cette même approche par « couches », explicites (comme les ‘tokens’) … ou latentes.

En effet, le réseau va spontanément reproduire des structures latentes proposant des regroupements statistiques en fonction de liens repérés dans les énormes corpora textuels donnés en apprentissage initial. Car le mécanisme primordial de « prédiction du mot suivant » reprend une mécanique très proche de l’approche LDA : des tokens (mots, ou bouts de mots) plongés dans des environnements, et établissant des liens latents entre eux.

Cela donne une approche hiérarchique implicite reproduisant certainement des couches latentes, telles (dans l’ordre micro vers macro) :

Ceci se lisant par exemple ainsi :

Si, lecteur curieux, tu es arrivé là 😉 alors une objection te viendra certainement : comment puis-je définir un raisonnement qui ne soit que pure corrélation / coïncidence, alors qu’un raisonnement est intuitivement logique, déductif ?

C’est un des points qui agite logiciens et philosophes depuis plusieurs siècles. On pourra ici penser à « l’enquête sur l’entendement » de David Hume, tenant du principe qu’un raisonnement logique est essentiellement une imitation de raisonnements appris… c’est le point de vu des « empiristes ».

À ce point, il sera donc certainement nécessaire de démultiplier les approches possibles (découverte causale ? logique floue ? exploration/explication régionalisée du modèle ? hybridation avec des ontologies, graphes de connaissances ?).

Mais notre pari est que les futures IA génératives devraient probablement se hiérarchiser explicitement, et s’hybrider pour être pleinement utilisables dans des cas d’usage à forts enjeux. Et que l’IA dans son ensemble devrait faire un bond conceptuel majeur, réalisant peut-être par là les promesses formulées dès 1956 et la conférence fondatrice de Darmouth.

La thèse de cet article est finalement que l’explicabilité des modèles de langage devrait donc passer par la découverte, et l’explicitation de ce que le modèle a appris de façon latente… ce qui est l’approche finalement classique des modèles.

C’est clairement un défi, scientifique, technologique, épistémologique en soi, au vu de l’énorme complexité des modèles (centaines de milliards de paramètres).

Comment à partir de cette analyse faire un pas significatif vers des modèles de génération de documents plus robustes, assurant la confidentialité ? Cette préoccupation d’explicabilité laisse imaginer (au moins) 2 approches :

AI-vidence travaillera ses sujets dans les prochains mois. Intéressé par une collaboration ? Contactez-nous !

Latent Dirichlet Allocation – David M. Blei – Andrew Y. Ng – Michael I. Jordan Nicolas Curien – variances.eu