La représentation la plus simple d’un « phénomène » que l’on cherche à modéliser se fait via des variables compréhensibles, et « statiques ». Cela est parfois suffisant pour comprendre un phénomène, quitte à n’en considérer qu’une vision simplifiée.

Or, les phénomènes (industriels, comportementaux, etc.) varient en général dans le temps. Comment garder la compréhension d’un phénomène (Normalité ? Anomalie ?) et la performance des modèles prédictifs quand le contexte (situation macro-économique ? Régime de fonctionnement d’une usine ?) varie ?

La récente remontée des taux directeurs des banques centrales après presque 15 ans de taux historiquement bas ont amené une situation en très rapide baisse de performance dans les prédictions du risque de défaut. Le doublement de la cadence de production d’un site industriel, et/ou évolution de certains composants de la chaine de production donnent des relations très différentes entre les composants d’un système.

Dans les deux cas, les modèles prédictifs utilisés jusqu’à ce changement majeur perdent beaucoup de leur pertinence pour les prédictions futures. La vision « statique » n’est ici plus suffisante : le présent ne ressemble plus assez au passé… il est nécessaire de considérer les évolutions dans le temps du modèle. Vivent les séries temporelles !

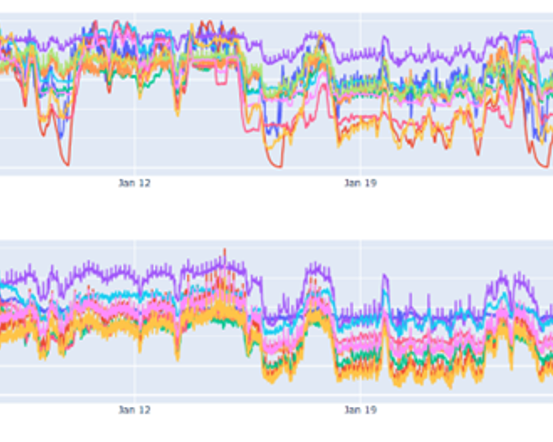

AI-vidence est intervenu avec la méthodologie et l’outil AntakIA pour détecter et classifier les différents types d’anomalies d’un vaste système de séries temporelles (env. 3000, issues de centaines de capteurs sur un site industriel). La complexité intrinsèque d’un tel système le rend extrêmement ardu à appréhender par un seul agent superviseur, au temps généralement compté. De plus, l’exposition aux conditions extérieures rend la stabilité des mesures incertaine.

Contextualiser les prévisions est donc nécessaire pour :

Nous avons donc procédé en plusieurs étapes :

1) Phase exploratoire des données :

Notre souci de rendre directement compréhensible par un expert métier les résultats de détection d’anomalies nous a amené à certaines étapes supplémentaires, particulièrement fécondes…

2) Modélisation explicable

C’est là la difficulté principale : les techniques les plus classiques d’explication reposent sur l’importance des prédicteurs pour une décision/prédiction. Sans retraitement, ces outils sont inefficaces pour des séries temporelles. En effet, une « explication » du type : « probabilité de défaut à 85% car la valeur numérique est 217,22 mardi 12 à 13h57 » n’est pas assez « plongée » dans un contexte pour être exploitable.

Nous avons donc introduit des indicateurs agrégés, plus intrinsèquement explicables, et entraîné un modèle de détection sur ces indicateurs.

L’approche régionale d’AI-vidence vise à rendre plus explicable, et par là plus contrôlable les systèmes prédictifs. En effet, l’approche AntakIA combine :

Pour en savoir davantage : voir les travaux d’Elisa Fromont de l’IRISA, ou voir le prochain atelier Datacraft sur AntakIA !